Multimodale KI:

Im November 2022 hat OpenAI ChatGPT veröffentlicht, und innerhalb weniger Tage hat dieses leistungsstarke Werkzeug die Welt im Sturm erobert. Mit seinen beispiellosen Fähigkeiten markierte ChatGPT den Beginn einer neuen Ära der generativen Künstlichen Intelligenz (KI). Doch während die Welt von den Möglichkeiten dieser Technologie fasziniert war, stellte sich schnell die Frage: Was kommt als Nächstes?

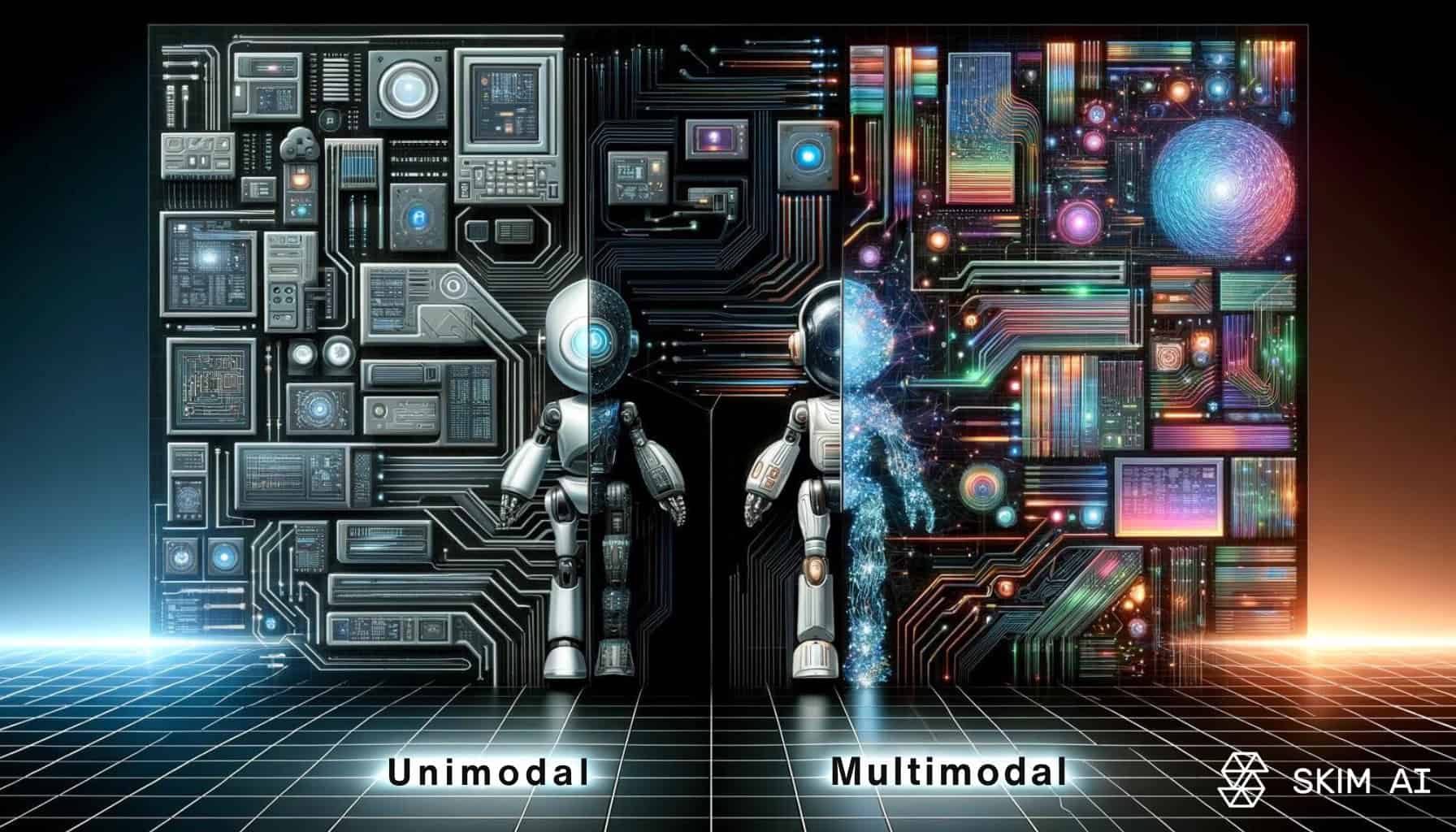

Zu dieser Zeit waren ChatGPT und viele andere generative KI-Werkzeuge, die auf großen Sprachmodellen (LLMs) basierten, darauf ausgelegt, Texteingaben von Benutzern zu verarbeiten und Textausgaben zu erzeugen. Diese KI-Tools wurden als unimodale Systeme bezeichnet, da sie nur eine Art von Daten – nämlich Text – verarbeiten konnten.

Doch dies war nur der Anfang. Wir kratzten lediglich an der Oberfläche dessen, was LLMs leisten können. Nur ein Jahr nach der Einführung von ChatGPT sind die Fortschritte in der Branche einfach erstaunlich, sodass es schwer fällt, die Grenzen des Möglichen zu erkennen. In unserem separaten Artikel über die langfristigen Auswirkungen von ChatGPT und generativer KI haben wir diese Entwicklungen eingehend analysiert.

Heute, wenn du dir die Frage stellst „Was kommt als Nächstes?“, lautet die beste Antwort wahrscheinlich: Multimodales Lernen. Dies ist einer der vielversprechendsten Trends in der laufenden KI-Revolution. Multimodale generative KI-Modelle sind in der Lage, verschiedene Arten von Eingaben zu kombinieren und Outputs zu erstellen, die ebenfalls mehrere Typen umfassen können.

Contents

Multimodale KI verstehen

Multimodale KI erweitert die Fähigkeiten traditioneller KI-Modelle erheblich. Während die ersten generativen KI-Modelle, wie ChatGPT, ausschließlich mit Texteingaben arbeiteten und Textausgaben erzeugten, geht multimodale KI einen Schritt weiter. Sie ist in der Lage, verschiedene Arten von Daten – wie Text, Bilder, Audio und Video – gleichzeitig zu verarbeiten und daraus umfassendere und genauere Ergebnisse zu liefern.

Warum ist das so wichtig? Um dies zu verstehen, müssen wir einen Blick darauf werfen, wie Menschen lernen. Unser Gehirn nutzt alle fünf Sinne, um Informationen aus der Umgebung zu sammeln. Diese Informationen werden in unserem Gedächtnis gespeichert, verarbeitet und genutzt, um neue Erkenntnisse zu gewinnen und Entscheidungen zu treffen. Ähnlich funktioniert multimodale KI: Sie integriert Daten aus verschiedenen Quellen, um ein vollständigeres Bild zu erhalten und bessere Vorhersagen und Entscheidungen zu treffen.

Ursprünglich waren KI-Modelle wie ChatGPT auf die Verarbeitung von Text beschränkt, da Textdaten nicht nur leicht zu speichern und zu verarbeiten sind, sondern auch in großen Mengen verfügbar sind. Dies machte es einfach, solche Modelle zu trainieren. Allerdings ist Lesen nur eine von vielen Möglichkeiten, wie Menschen lernen, und in vielen Fällen nicht die effektivste.

Multimodales Lernen ist ein Teilbereich der KI, der die Lernkapazität von Maschinen erweitert, indem sie mit großen Mengen an Text sowie anderen Datentypen, wie Bildern, Videos oder Audiodateien, trainiert werden. Dadurch können Modelle neue Muster und Korrelationen zwischen Textbeschreibungen und ihren zugehörigen Bildern, Videos oder Audiodaten lernen.

Diese Fähigkeit, verschiedene Datentypen zu kombinieren, eröffnet neue Möglichkeiten für intelligente Systeme. Multimodale KI-Modelle können mehrere Eingabemodalitäten verarbeiten und mehrere Ausgabemodalitäten erzeugen. Ein Beispiel dafür ist GPT-4, das sowohl Bild- als auch Texteingaben akzeptieren und Textausgaben generieren kann. Ein weiteres Beispiel ist das kürzlich angekündigte Sora-Text-zu-Video-Modell von OpenAI.

Kernkonzepte der Multimodalen KI

Multimodale KI-Modelle bringen eine neue Ebene der Komplexität in die bereits fortschrittlichen großen Sprachmodelle (LLMs) ein. Diese Modelle basieren auf einer Art neuronaler Architektur, die als Transformer bekannt ist. Transformer-Modelle, entwickelt von Forschern bei Google, nutzen eine Encoder-Decoder-Architektur und das Attention-Mechanismus, um die effiziente Verarbeitung von Daten zu ermöglichen.

Um zu verstehen, wie multimodale KI funktioniert, müssen wir uns mit den Konzepten der Datenfusion beschäftigen. Datenfusion ist der Prozess, bei dem unterschiedliche Datentypen kombiniert werden, um ein vollständigeres und genaueres Verständnis der zugrunde liegenden Informationen zu gewinnen. Abhängig davon, in welchem Stadium die Fusion stattfindet, können wir die Techniken der Datenfusion in drei Kategorien einteilen:

- Early Fusion: Diese Technik kodiert die verschiedenen Modalitäten in das Modell, um einen gemeinsamen Repräsentationsraum zu schaffen. Das Ergebnis ist eine Modalität-invariante Ausgabe, die die semantischen Informationen aller Modalitäten enthält.

- Mid Fusion: Hier werden die Modalitäten in verschiedenen Vorverarbeitungsstufen kombiniert. Dies wird durch spezielle Schichten im neuronalen Netzwerk erreicht, die speziell für die Zwecke der Datenfusion entwickelt wurden.

- Late Fusion: Diese Methode beinhaltet die Erstellung mehrerer Modelle zur Verarbeitung der verschiedenen Modalitäten. Die Ausgabe jedes Modells wird dann in einer neuen algorithmischen Schicht kombiniert.

Es gibt keine universelle Datenfusionstechnik, die für alle Szenarien am besten geeignet ist. Stattdessen hängt die Wahl der Technik von der spezifischen multimodalen Aufgabe ab. Daher ist oft ein Prozess des Ausprobierens und Anpassens erforderlich, um die am besten geeignete multimodale KI-Pipeline zu finden.

Die Fähigkeit, verschiedene Datenmodalitäten zu kombinieren, beruht auf fortschrittlichen Datenverarbeitungstechniken und umfassendem Wissen in mehreren KI-Teilbereichen. Diese Fortschritte in der Datenfusion und den zugrunde liegenden Technologien haben multimodale KI-Modelle hervorgebracht, die in der Lage sind, verschiedenste Eingaben zu verarbeiten und ebenso vielfältige Ausgaben zu generieren.

Herausforderungen bei der Implementierung Multimodaler KI-Lösungen

Obwohl die multimodale KI zahlreiche Möglichkeiten für Unternehmen, Regierungen und Einzelpersonen bietet, gibt es auch erhebliche Herausforderungen bei der Implementierung dieser Technologien. Hier sind einige der wichtigsten Hindernisse:

Identifizierung Geeigneter Anwendungsfälle

Eine der größten Herausforderungen besteht darin, die richtigen Anwendungsfälle für multimodale KI zu finden, die den spezifischen Bedürfnissen entsprechen. Der Übergang von der Konzeptphase zur tatsächlichen Implementierung ist nicht immer einfach, insbesondere wenn es an Fachwissen fehlt, das die technischen Details hinter multimodaler KI versteht.

Fachkräftemangel und Kosten

Multimodale KI erfordert spezialisierte Kenntnisse in verschiedenen Bereichen der KI und Datenwissenschaft. Angesichts der aktuellen Datenkompetenzlücke kann es schwierig und kostspielig sein, die richtigen Talente zu finden und zu binden, da Unternehmen bereit sind, hohe Summen zu zahlen, um diese begrenzten Fachkräfte anzuziehen.

Technische Hürden und Komplexität

Die Entwicklung und Implementierung multimodaler KI-Modelle ist technisch anspruchsvoll. Es erfordert erhebliche Rechenressourcen und fortschrittliche Algorithmen, um die verschiedenen Modalitäten zu integrieren und effektiv zu verarbeiten. Diese Komplexität kann die Implementierung verzögern und zusätzliche Kosten verursachen.

Ressourcen- und Kostenaufwand

Generative KI-Modelle, insbesondere multimodale, benötigen erhebliche Rechenressourcen, was mit hohen Kosten verbunden ist. Vor der Einführung einer generativen KI-Lösung ist es wichtig, die benötigten Ressourcen abzuschätzen und die damit verbundenen Kosten zu berücksichtigen.

Datenqualität und -integration

Die Genauigkeit und Leistung multimodaler KI-Modelle hängt stark von der Qualität und Integration der Daten ab, die sie verarbeiten. Unterschiedliche Datentypen müssen harmonisiert und synchronisiert werden, um sinnvolle Ergebnisse zu erzielen. Dies kann besonders herausfordernd sein, wenn Daten aus unterschiedlichen Quellen und Formaten stammen.

Fazit

Das Aufkommen multimodaler KI-Modelle markiert einen bedeutenden Wendepunkt in der Entwicklung und Anwendung künstlicher Intelligenz. Diese fortschrittlichen Modelle erweitern die Fähigkeiten bestehender Technologien, indem sie verschiedene Datentypen wie Text, Bilder, Audio und Video integrieren und verarbeiten können. Dadurch eröffnen sich völlig neue Möglichkeiten für die Mensch-Maschine-Interaktion und die Entwicklung innovativer Anwendungen in verschiedensten Bereichen.

Die Vorteile multimodaler KI sind weitreichend und vielseitig. Von der Generierung von Inhalten über die Unterstützung im Gesundheitswesen bis hin zur Umweltüberwachung und der Verbesserung von Sicherheitssystemen – die Anwendungen sind nahezu unbegrenzt. Gleichzeitig gibt es jedoch auch erhebliche Herausforderungen und Risiken, die sorgfältig adressiert werden müssen. Dazu gehören Fragen der Transparenz, ethische Überlegungen, Datenschutz, der ökologische Fußabdruck und die Notwendigkeit spezialisierter Fachkräfte.

Um das volle Potenzial multimodaler KI auszuschöpfen, ist es entscheidend, diese Technologien verantwortungsvoll zu entwickeln und einzusetzen. Unternehmen, Regierungen und Forschungseinrichtungen müssen zusammenarbeiten, um sicherzustellen, dass multimodale KI-Modelle fair, transparent und nachhaltig sind. Nur so können wir sicherstellen, dass diese Technologien nicht nur den technologischen Fortschritt fördern, sondern auch zum Wohl der Gesellschaft beitragen.

Danke fürs Lesen 😉

Wenn dir dieser Beitrag gefallen hat, wird dich sicher auch folgender Artikel interessieren:

ChatLLM: Effiziente KI für Kommunikation & Datenanalyse

Entdecke mehr von AI News Daily

Subscribe to get the latest posts sent to your email.