Die Landschaft der Künstlichen Intelligenz ist von ständigen Fortschritten und Durchbrüchen geprägt. Eines der jüngsten Highlights in diesem Feld ist die Entwicklung von RAFT (Retrieval Augmented Fine Tuning), einer innovativen Methode, die das Potenzial hat, die Art und Weise, wie große Sprachmodelle in spezialisierten Domänen eingesetzt werden, grundlegend zu verändern. In diesem Artikel werfen wir einen Blick auf die Ergebnisse und Implikationen der Studie „RAFT: Adapting Language Model to Domain Specific RAG“ von Forschern der University of California, Berkeley.

Contents

Die Herausforderung: Spezialisierung von LLMs

Große Sprachmodelle haben in einer Vielzahl von Anwendungsfällen beeindruckende Ergebnisse erzielt. Von der Beantwortung allgemeiner Wissensfragen bis hin zur Textgenerierung haben diese Modelle gezeigt, dass sie ein breites Spektrum an Aufgaben bewältigen können. Doch wenn es um spezialisierte Bereiche geht – sei es Medizin, Recht oder Technik – stoßen die Standardmethoden an ihre Grenzen. Der Grund dafür ist, dass die spezifischen Informationen und das Fachvokabular dieser Domänen oft weit über das hinausgehen, was in den allgemeinen Trainingsdaten der Modelle enthalten ist.

RAFT: Eine Lösung für das Problem

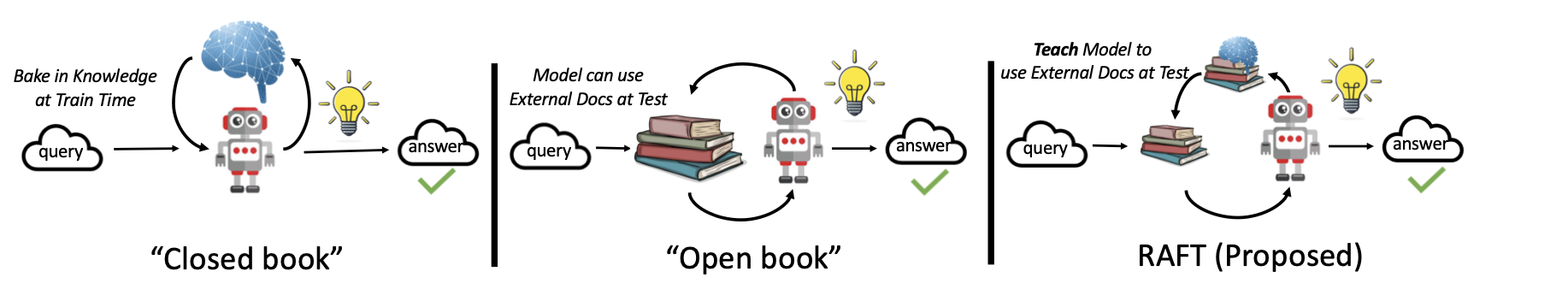

Um diese Herausforderung zu meistern, haben die Forscher RAFT entwickelt. Diese Methode trainiert das Modell darauf, sich auf die relevanten Informationen zu konzentrieren und alles Irrelevante zu ignorieren. Der Ansatz ähnelt der Vorbereitung auf eine offene Buchprüfung, bei der es nicht nur darauf ankommt, das Material zu kennen, sondern auch zu wissen, wie man die relevanten Informationen effektiv nutzt.

Konzept und Funktionsweise

RAFT arbeitet mit einem Set aus Fragen und dazugehörigen Dokumenten. Das Modell wird trainiert, nur die Dokumente für die Beantwortung einer Frage zu verwenden, die tatsächlich hilfreich sind, und dabei sogenannte „Distraktor-Dokumente“ zu ignorieren. Dies verbessert nicht nur die Fähigkeit des Modells, relevante Informationen zu erkennen, sondern lehrt es auch, eine Kette von Gedanken zu entwickeln, die zur korrekten Antwort führt.

Vorteile von RAFT

Der größte Vorteil von RAFT liegt in seiner Anwendung auf domänenspezifisches Retrieval-Augmented Generation (RAG). In praktischen Anwendungen, wo Modelle mit spezifischen Dokumentensammlungen arbeiten, bietet RAFT einen signifikanten Leistungsvorteil. Es ermöglicht präzise und kontextbezogene Antworten, die für die jeweilige Domäne maßgeschneidert sind.

Einsatzmöglichkeiten und Zukunftsperspektiven

RAFT öffnet die Tür für eine Vielzahl von Anwendungen in Bereichen, in denen Fachwissen von entscheidender Bedeutung ist. Von der medizinischen Diagnostik über die Rechtsberatung bis hin zum technischen Support kann RAFT dazu beitragen, die Genauigkeit und Relevanz von KI-gestützten Antworten erheblich zu verbessern.

Die Studie zeigt nicht nur einen Weg auf, wie die Herausforderungen der Spezialisierung von LLMs überwunden werden können, sondern legt auch den Grundstein für zukünftige Forschungen in diesem Bereich. Mit der kontinuierlichen Entwicklung von KI und maschinellem Lernen steht uns eine Zukunft bevor, in der Modelle immer genauer auf unsere spezifischen Bedürfnisse und Anforderungen zugeschnitten sind.

Entdecke mehr von AI News Daily

Subscribe to get the latest posts sent to your email.